DIGITIMES Research:深度感測器為移動機器人導航效能關鍵 視覺SLAM挑戰LiDAR SLAM路途仍遙

DIGITIMES Research:深度感測器為移動機器人導航效能關鍵 視覺SLAM挑戰LiDAR SLAM路途仍遙。(DIGITIMES Research提供)

DIGITIMES Research:深度感測器為移動機器人導航效能關鍵 視覺SLAM挑戰LiDAR SLAM路途仍遙。(DIGITIMES Research提供)

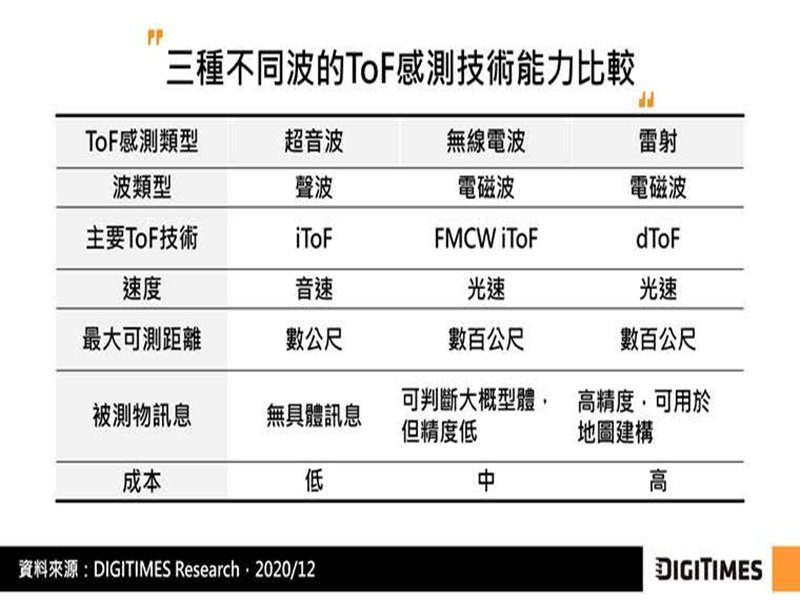

導航(navigation)是移動機器人(mobile robot)最重要的能力之一,透過採用飛時測距(Time of Flight;ToF)或雙眼視覺(stereoscopic vision)技術的2D或3D深度感測器(depth sensor),移動機器人可即時取得空間訊息並進行SLAM (Simultaneous Localization And Mapping)運算以建構地圖及定位。不同測距技術在精度、可測範圍、運算資源耗用及成本上皆各有優劣,並無單一最佳方案。

移動機器人領域常用的深度感測器包括2D或3D光達、雙眼相機(stereoscopic camera)、ToF相機、雷達(Radio Detection And Ranging;RADAR)及超音波雷達(ultrasonic radar)等,除雙眼相機採雙眼視覺技術進行測距,其他感測器皆採ToF技術。

ToF中的dToF (direct ToF)因直接採用單一脈衝計算時間差,在可量測範圍及精度表現優於iToF (indirect ToF)及雙眼視覺,因此被廣泛用於2D與3D機械光達(mechanical LiDAR)中。iToF解析度及功耗表現優於dToF,但受制於採用連續波(continuous wave)的安全與技術限制,可測距離不如dToF,但精度表現較佳。

雙眼相機近年因成本顯著低於ToF感測器,加上借力採用深度學習(deep learning)的電腦視覺(Computer Vision;CV),及視覺SLAM演算法快速發展,受巿場重視程度不斷提升,然其最大痛點在於所測深度誤差隨距離呈指數擴大,導致其可測距離不如ToF感測器。

DIGITIMES Research分析師蕭聖倫指出,感測器接收空間訊息後,機器人導航系統(robot navigation system)需進行地圖建構(map-building/mapping)、自我定位(self-localization)及路徑規劃(path planning)作業,而SLAM因可同時完成地圖建構與自我定位,為機器人導航中最關鍵技術。目前2D LiDAR SLAM因技術較為成熟,採用者較多,但視覺SLAM在雙眼相機易於取得、演算法進展及英特爾(Intel)積極推廣下,正受到巿場越來越多重視。

移動機器人領域常用的深度感測器包括2D或3D光達、雙眼相機(stereoscopic camera)、ToF相機、雷達(Radio Detection And Ranging;RADAR)及超音波雷達(ultrasonic radar)等,除雙眼相機採雙眼視覺技術進行測距,其他感測器皆採ToF技術。

ToF中的dToF (direct ToF)因直接採用單一脈衝計算時間差,在可量測範圍及精度表現優於iToF (indirect ToF)及雙眼視覺,因此被廣泛用於2D與3D機械光達(mechanical LiDAR)中。iToF解析度及功耗表現優於dToF,但受制於採用連續波(continuous wave)的安全與技術限制,可測距離不如dToF,但精度表現較佳。

雙眼相機近年因成本顯著低於ToF感測器,加上借力採用深度學習(deep learning)的電腦視覺(Computer Vision;CV),及視覺SLAM演算法快速發展,受巿場重視程度不斷提升,然其最大痛點在於所測深度誤差隨距離呈指數擴大,導致其可測距離不如ToF感測器。

DIGITIMES Research分析師蕭聖倫指出,感測器接收空間訊息後,機器人導航系統(robot navigation system)需進行地圖建構(map-building/mapping)、自我定位(self-localization)及路徑規劃(path planning)作業,而SLAM因可同時完成地圖建構與自我定位,為機器人導航中最關鍵技術。目前2D LiDAR SLAM因技術較為成熟,採用者較多,但視覺SLAM在雙眼相機易於取得、演算法進展及英特爾(Intel)積極推廣下,正受到巿場越來越多重視。